闇の奥:人工知能の奥にはどんな闇が隠されているのか?

|

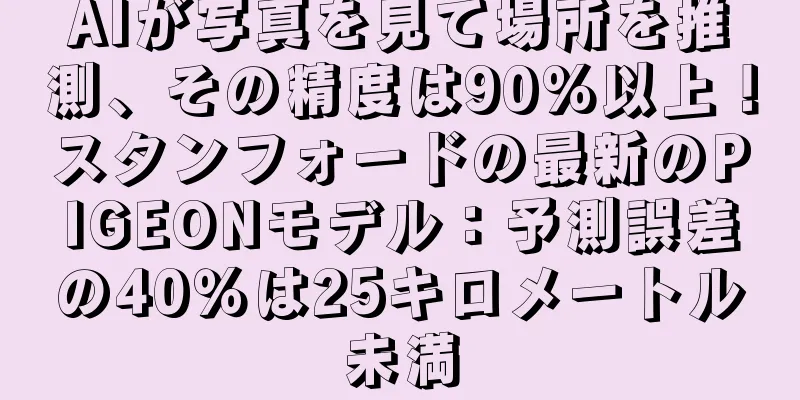

4月13日、TechnologyReviewによると、ロボットが倉庫への特定のルートを取ることを決定したり、自動運転車が左折または右折することを決定したりする場合、人工知能(AI)アルゴリズムは何を頼りに決定を下すのでしょうか?現在、AIは特定の決定を下す理由を人々に説明することができず、これは明らかにする必要がある大きな問題である可能性があります。

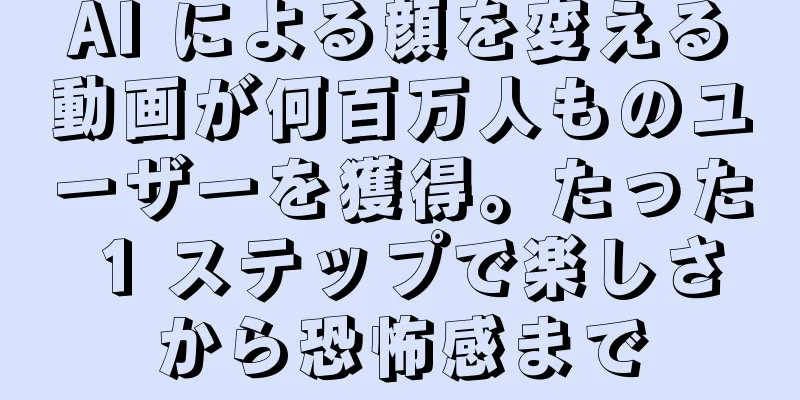

2016年、アメリカ・ニュージャージー州モンマス郡の静かな道路に奇妙な自動運転車が現れた。これはチップメーカーのNvidiaの研究者らが開発した実験車で、Google、Tesla、General Motorsが開発した自動運転車と見た目は変わらないものの、人工知能のより大きな力を実証している。 自動車の自動運転を支援するのは素晴らしい偉業ですが、自動車がどのように判断を下すのかをまだ完全には理解していないため、少し不安になることもあります。車のセンサーによって収集された情報は、大規模な人工ニューラルネットワークに直接送られ、そこでデータが処理され、車のステアリング、ブレーキ、その他のシステムの操作に関する指示が出される。 表面的には、人間のドライバーの反応と一致しているように見えます。しかし、木に衝突したり、信号を無視したりするなど、予期せぬことが起こると、その理由を突き止めるのが難しくなります。これらの AI アルゴリズムは非常に複雑なため、それを設計したエンジニアでさえ無力です。現時点では、なぜそのような決定を下したのかを常に人々に説明できるシステムを設計する方法はありません。 これらの自動運転車の「神秘的な意識」は、AIに関連する差し迫った問題を指摘している。これらの自動車アルゴリズムは、ディープラーニングと呼ばれる AI 技術に基づいており、近年、幅広い問題を解決するための強力なツールであることが証明されています。この技術は、画像キャプション作成、音声認識、言語翻訳などの分野で広く使用されています。現在、同じテクノロジーが、致命的な病気の診断、数百万ドル規模の取引の決定、その他業界全体を変革する可能性のある無数の事柄に役立つことが期待されています。 しかし、ディープラーニングなどの技術をその作成者が理解しやすくし、その動作をユーザーに説明しやすくする新しい方法が見つかるまでは、それは実現しないでしょうし、実現するべきでもありません。そうしないと、いつ失敗するかを予測することが難しくなり、失敗は避けられなくなります。これが、Nvidia の自動運転車がまだテスト段階にある理由の 1 つです。 数学モデルは現在、誰に仮釈放を与えるべきか、誰に融資を受けるべきか、誰を雇用すべきかを判断するのに役立てられている。これらの数値モデルにアクセスできる場合は、おそらくその理由を理解できるでしょう。しかし、銀行、軍隊、雇用主などは現在、自動化された意思決定をさらに奇妙なものにするのに役立つ、より高度な機械学習に注目し始めており、ディープラーニングはコンピューターのプログラミング方法を根本的に変える可能性がある。 「これは現在だけでなく、将来の多くの問題にも関係します」とMITの機械学習教授トミ・ヤッコラ氏は言う。「投資の決定、医療の決定、軍事の決定のいずれであっても、このブラックボックスに単純に頼ることはできません。」 AI システムがどのように結論や決定に至ったかを尋ねることは基本的な法的権利であるべきだという提案がなされている。 2018年夏以降、EUは企業に対し、自動化システムによる決定の理由をユーザーに提供することを要求する可能性がある。これは、ディープラーニングを使用して広告を配信したり曲を推奨したりするアプリやウェブサイトなど、一見比較的単純なシステムであっても不可能に思えます。これらのサービスを実行しているコンピューターはすでにプログラミングされており、私たちには理解できない方法で動作しており、これらのアプリケーションを開発したエンジニアでさえその動作を明確に説明することはできません。 これにより、多くの驚くべき疑問が生じます。テクノロジーが進歩するにつれ、AI の飛躍に役立ついくつかの限界をすぐに超えることになるかもしれません。私たち人間は自分の思考プロセスを常に説明できるわけではありませんが、直感を通じて誰かを信頼したり判断したりする方法を見つけることはできます。機械は人間のような心を持っているのでしょうか? これまで、製作者がその仕組みを理解できない機械は開発されていません。私たちは、予測不可能で理解不能なこれらのインテリジェントな機械とどのようにコミュニケーションし、調和して生活できるのでしょうか? これらの疑問から、私は Apple から Google まで、さまざまな場所で AI アルゴリズムを解読する旅に出て、当代で最も偉大な哲学者の 1 人に会うことさえできました。

2015年、ニューヨークのマウントサイナイ病院の研究チームは、病院の膨大な症例データベースにディープラーニングを適用することを思いつきました。このデータセットには、検査結果や医師の診断など、患者に関連する数百の変数が含まれています。研究者らが「Deep Patient」と名付けたこのプログラムは、70万人以上の患者のデータを使ってトレーニングされた。しかし、新たな症例でテストしたところ、驚くべき能力が示され、病気を予測するのに非常に優れていた。 Deep Patient は専門家の指導なしに、病院のデータに隠れたパターンを見つけ出し、患者のさまざまな症状を通じて肝臓がんなどの病気を確認することができます。 「医療データを使って病気を予測する方法はたくさんあるが、われわれの方法はより優れている」とマウント・サイナイ・チームでプロジェクトを率いたジョエル・ダドリー氏は語った。 同時に、Deep Patient は統合失調症などの精神疾患の診断に非常に正確であるため、少し混乱を招きます。しかし、統合失調症は医師にとっても診断が難しいことで有名であるため、ダドリー氏はディープ・ペイシェントがなぜこのような能力を持っているのかを知りたかったが、答えは見つからず、新しいツールも何の手がかりも与えなかった。 Deep Patient のようなツールが医師を支援するのであれば、結論の正確性を確保するために予測的推論を提供するのが理想的です。しかし、「モデルを構築することはできるが、彼らがどのように決定を下すのかは実際には分からない」とダドリー氏は言う。 AI の場合、必ずしもそうではありませんでした。当初から、AI をどのように理解し、説明するかについては 2 つの考え方がありました。多くの人は、ルールとロジックに従って開発されたマシンは、内部の仕組みが透明で誰でもコードを調べることができるため、最も理にかなっていると考えています。機械が生物学からヒントを得て、観察と経験を通じて学習できれば、知能が出現する可能性が高くなると主張する人もいる。これは、コンピューターにプログラミング機能があることを意味します。問題を解決するためにプログラムに指示を入力する必要はなく、プログラム自体がサンプルデータと必要な出力に基づいてアルゴリズムを生成します。後者のモデルによれば、この機械学習技術は後に、機械自体がプログラムとなる今日の最も強力な AI システムへと進化しました。 当初、このアプローチの実用性は非常に限られており、1960 年代から 1970 年代にかけては依然として主に「分野の端」に限定されていました。その後、多くの産業のコンピュータ化と大規模なデータセットの出現により、新たな関心が巻き起こりました。これにより、より強力な機械学習技術、特に人工ニューラル ネットワークと呼ばれる最新の技術の出現が促進されました。 1990 年代までに、ニューラル ネットワークは手書き文字を自動的にデジタル化できるようになりました。 しかし、いくつかの巧妙な調整と改良を経て、より大規模でより深いニューラル ネットワークが自動認識において大きな進歩を遂げたのは、2010 年代初頭になってからでした。ディープラーニングは、今日の AI の爆発的な成長の主な原動力です。ディープラーニングにより、コンピューターは、人間のように話し言葉を認識する能力や、複雑なコードを手動で機械に入力する代わりに使用する能力など、並外れた能力を獲得します。ディープラーニングはすでにコンピュータービジョンを変革し、機械翻訳を劇的に改善しました。現在、医療、金融、製造などの分野で重要な意思決定を導くために使用されています。 手動でコーディングされたシステムと比較すると、機械学習技術の仕組みは、コンピューター科学者にとっても本質的に不明瞭です。将来のすべての AI テクノロジーが同じように予測不可能であると言っているわけではありませんが、その性質上、ディープラーニングは特に暗い「ブラックボックス」です。ディープ ニューラル ネットワークの内部を見て、それがどのように動作するかを確認することはできません。ネットワーク推論は、実際には、数十または数百の複雑に相互接続された層に配置された、数千のシミュレートされたニューロンの共同動作です。最初の層の各ニューロンは、画像内のピクセルの強度などの入力を受け取り、計算を実行して、新しい信号を出力します。これらの出力は、より複雑なネットワーク、つまり次のニューロン層に送られます。このプロセスは、全体的な出力結果が最終的に生成されるまで、レイヤーごとに実行されます。さらに、「バックプロパゲーション」と呼ばれるプロセスがあり、これにより、ネットワークは個々のニューロンの計算を調整することによって生成する必要がある「望ましい出力」を学習できます。

ディープ ネットワークの多層構造により、さまざまな抽象レベルで物事を認識できます。たとえば、犬を認識するように設計されたシステムでは、下位層は色や輪郭などの単純なものを認識し、上位層は毛皮や目などのより複雑なものを認識し、最上位層は対象が犬であると判断することになります。同じアプローチは、会話で使用される単語の発音、テキスト内の文章を構成する文字や単語、運転に必要なハンドルの動きなど、機械が自ら学習できるようにする他の入力にも適用できます。 これらのシステムで何が起こっているかをより詳細に捉えて説明するために、研究者はいくつかの巧妙な戦略を採用しています。 2015年、Googleの研究者はディープラーニングに基づいて開発された画像認識アルゴリズムを修正し、画像内の物体を発見する必要がなくなり、代わりに物体を生成したり修正したりできるようになりました。アルゴリズムを効果的に逆順に実行することで、鳥や建物を識別するのに使用できることがわかった。 「ディープ・ドリーム」と呼ばれるプログラムによって作成された画像には、雲や木の葉から現れる奇妙な動物や、森や山に現れる幻想的な仏塔などが映っている。これらの画像は、ディープラーニングがまったく理解できないものではなく、アルゴリズムには鳥のくちばしや羽などの馴染みのある視覚的特徴も必要であることを証明しています。しかし、これらの画像は、ディープラーニングが人間の知覚とは大きく異なり、私たちが無視している物事を信じられないように見せることができることも示しています。 Google の研究者は、アルゴリズムがダンベルの画像を生成すると、それを持った人間の腕も生成されることに気付きました。機械は腕がダンベルの一部であると結論付けました。 この技術は、神経科学や認知科学の分野のアイデアを活用することでさらに進歩しました。ワイオミング大学の准教授ジェフ・クルーネ氏が率いるチームは、錯視AIを使用してディープニューラルネットワークをテストした。 2015年、クルーネ氏のチームは、システムが探していた低レベルのパターンを画像が利用することで、特定の画像がニューラルネットワークを騙して物体が存在しないと思わせる仕組みを示した。クルーネ氏の同僚ジェイソン・ヨシンスキー氏も、ネットワークの中央にあるニューロンをターゲットにして、ニューロンを活性化させる可能性が最も高い画像を探す同様のプローブを開発した。これらの画像は抽象的に見えますが、機械の知覚の神秘的な性質を浮き彫りにしています。 しかし、AI の心を覗き見ることはできないだけでなく、簡単な解決策もありません。ディープ ニューラル ネットワーク内での計算の相互作用は、高レベルのパターン認識と複雑な意思決定にとって重要ですが、これらの計算は数学的な関数と変数の泥沼です。 「非常に小さなニューラルネットワークであれば、理解できるかもしれません」とジャケラ氏は言う。「しかし、各層に数千のユニットがあり、層が数百もあるような非常に大きなものになると、理解するのはかなり難しくなります。」 ジャケラ氏の同僚であるレジーナ・バルジレイ氏は、機械学習を医療に応用することに重点を置いています。 2年前、43歳のとき、バルジライさんは乳がんと診断された。診断自体が衝撃的だったが、バルジライ氏は、最先端の統計的手法や機械学習の手法がまだ腫瘍学の研究や治療の指針として活用されていないことにも不満を感じていた。 AIは医療業界に革命を起こす可能性を秘めており、その可能性を実現すれば、医療分野以外にもAIを活用できるようになると彼女は述べた。彼女は、画像データや病理データなど、十分に活用されていない生データをさらに活用したいと考えています。 昨年、がん治療を終えた後、バルジライ氏と学生たちはマサチューセッツ総合病院の医師らと協力し、病理報告書を分析して研究者が研究したい特定の臨床症例を持つ患者を特定できるシステムの開発に着手した。しかし、バルジライ氏は、システムがその根拠を説明できる必要があることを理解していました。この目的のために、バルジライ氏、ジャケラ氏らは、システムがすでに発見されているパターンにも含まれるテキスト内の断片を抽出して強調表示できるという新たな研究を追加しました。バルジライ氏らは、マンモグラムで乳がんの初期症状を検出できるディープラーニングアルゴリズムも開発した。彼らの目標は、このシステムに推論を説明する同じ能力を与えることです。 「機械と人間がより協力して連携できるループが本当に必要です」とバルジライ氏は言う。 米軍は、車両や航空機の誘導、標的の特定、アナリストによる大量の情報データの精査を支援するために機械学習を使用するプロジェクトに数十億ドルを投資している。他の分野の研究とは異なり、米国国防総省は、説明可能性が AI アルゴリズムの謎を解明する上での重要な障害であると認識しています。国防総省の研究開発機関である DARPA のプログラム ディレクターである David Gunning 氏は、「説明可能な人工知能」と呼ばれるプロジェクトを監督しています。同氏は以前、Siri の開発につながった DARPA プログラムの監督に携わっていました。 甘寧氏は、自動化は数え切れないほどの軍事分野に浸透していると述べた。諜報アナリストは、膨大な量の諜報データ内のパターンを識別する新しい方法として機械学習をテストしています。多くの無人地上戦闘車両や航空機が開発され、テストされているが、兵士たちは自ら説明できないロボット戦車に座ることに不安を感じるかもしれないし、アナリストたちは論理的根拠のない情報に基づいて行動することを躊躇する。 「こうした機械学習システムは、その性質上、誤報を多く生成することが多く、ネットワークアナリストは、なぜそのような推奨を行っているのかを理解するために追加の支援を必要としている」とガニング氏は述べた。 3月に、DARPAはワシントン大学のカルロス・ゲストリン教授が率いるプロジェクトを含む、ガニング氏のチームによる資金提供のために学界と産業界からの13のプロジェクトを選定した。ガストリン氏とその同僚は、機械学習システムがその出力の推論を提供できるようにする新しい方法を発見した。本質的には、彼らの方法により、コンピューターはデータセット内の例を自動的に見つけ、それを裏付ける証拠として使用できるようになります。たとえば、テロリストの電子メール メッセージを分類できるシステムでは、トレーニングと意思決定に数千万件のメッセージを使用する必要がある場合があります。しかし、ワシントン大学チームの方法を使用すれば、情報に現れる特定のキーワードを強調表示することができます。ガストリン氏のチームは、画像の最も重要な部分を強調表示することで推論をサポートする画像認識システムも設計しました。 この手法や他の同様の手法の欠点は、提供される説明が常に簡略化されているため、多くの重要な情報が失われる可能性があることです。 「AIがあなたと会話し、物事を説明できるようになるという夢はまだ完全には実現されていません」とガストリン氏は言う。「真に説明可能なAIの実現にはまだまだ遠いのです。」 AI の推論を理解することは、がんの診断や軍事演習のような重大な領域において非常に重要になるだけでなく、このテクノロジーが日常生活の一部になったときにも、AI が説明を提供できることが同様に重要になります。 AppleのSiriチームを率いるトム・グルーバー氏は、Siriをより賢く、より有能なバーチャルアシスタントにするために、説明可能性はチームにとって重要な要素であると語った。グルーバー氏はSiriの将来についての具体的な計画については語らなかったが、Siriからレストランの提案を受けた場合、その理由を知りたいと思うだろうことは容易に想像できる。 AppleのAI研究ディレクターであり、カーネギーメロン大学の准教授でもあるルスラン・サラクディノフ氏は、説明可能性を人間とインテリジェントマシンの進化する関係の中心に据えている。 人間の行動の多くが説明できないのと同じように、おそらく AI も自らの行動のすべてを説明できるわけではないでしょう。 「誰かがもっともらしい説明をしてくれたとしても、それでは十分ではないかもしれません。AIについても同じことが言えます」とクルーネ氏は言う。「一部の行動だけが推論で説明できるというのは、知性の本質的な部分なのかもしれません。一部の行動は単なる本能的なもの、無意識的なもの、あるいはまったく理由がないものです」。これが事実なら、ある段階で私たちはAIの判断を絶対的に信頼するか、まったく使わないかしなければならないかもしれない。繰り返しますが、この判断には社会的知性が組み込まれなければなりません。社会が期待される行動の契約に基づいて構築されているのと同様に、私たちは社会のルールに従い、それに適応する AI システムを設計する必要があります。ロボット戦車やその他の殺人マシンを製造したい場合、その決定は私たちの道徳的判断と一致している必要があります。 これらの抽象概念を探求するために、私はタフツ大学の著名な哲学者であり認知科学者であるダニエル・デネットに目を向けました。デネットは最新著書『バクテリアからバッハへ、そしてバクテリアからバッハへ』の中で、知能の進化の本質は、その作成者が実行方法を知らなかったタスクを実行できるシステムを作成することにあると主張している。 「問題は、そのために私たちがどんな努力をしなければならないか、そして私たちが彼らに求める基準、つまり私たち自身の基準は何かということです」とデネット氏は語った。 ダニエル氏はまた、説明可能な AI の探求について警告を発し、「これらのものを使用し、それらに頼るのであれば、それらがどのようにして、そしてなぜその答えを出すのかをできる限りしっかりと把握する必要があると思います」と述べました。しかし、まだ完璧な答えは存在しないため、機械がどれだけ賢くなっても、AI の説明可能性については慎重になるべきです。 「彼らが私たちよりもうまく説明できないのであれば、彼らを信頼すべきではない」とデネット氏は語った。 |

>>: Googleの新しいAIツールはAppleのバッチ処理ツールに似ている

推薦する

人工知能がいかに「知的」であっても、それは人類の奇跡である

テレビ番組「ザ・ブレイン」が巻き起こした「人間対機械」、そして自動運転車、顔認識、アルファ囲碁など一...

RSA-PSSアルゴリズムを一緒に学びましょう

[[400577]] AS(5): RSA-PSSアルゴリズムの紹介2018 年にリリースされた T...

基本的なアルゴリズムについての簡単な説明: AVL ツリーとスプレイ ツリー (パート 3)

順序上記に引き続き、このトピックについて話し続けましょう。バランス二分木: AVL 木 (1962)...

機械学習の経験を人生の指針に活用する: 学習効率を最大化する方法

[[185313]]原作者 | ライムンド・マンテローラ編集チーム | Aileen、Huang W...

Transformer の再考: 反転がより効果的になり、現実世界の予測のための新しい SOTA が出現

トランスフォーマーは、ペアワイズ依存関係を記述し、シーケンス内のマルチレベル表現を抽出できるため、時...

マスク氏「高度なAIの開発は非常にリスクが高い。OpenAIはアルトマン氏を解雇した理由を明らかにすべき」

11月20日、テスラのCEOイーロン・マスク氏は、高度な人工知能(AI)技術の開発には大きな潜在的...

行動バイオメトリクスと機械学習が顧客関係を改善する方法

行動バイオメトリクスは、トラブルのない認証を実現し、世界中の消費者の体験に革命をもたらす画期的なテク...

人工知能時代の未来の教育

未来は、私たちが行く場所であるだけでなく、私たちが創り出す場所でもあるので、単なる時間の概念ではあり...

ガートナー 2019 人工知能成熟サイクルのトレンド

このガートナーのハイプサイクルは、AIが企業に及ぼすさまざまな影響を強調しています。ガートナーの 2...

主流のブロックチェーンコンセンサスアルゴリズムの包括的なガイド

あらゆる優れた暗号通貨の背後には、優れたコンセンサス アルゴリズムが存在します。完璧なコンセンサス ...