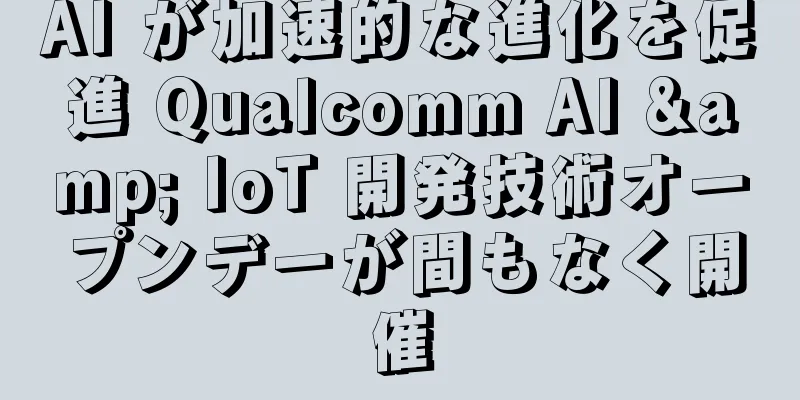

GoogleのオープンソースビッグモデルGemmaは何をもたらすのか?「Made in China」のチャンスはすでに到来していることが判明

|

Google の珍しいオープン AI は、オープンソースのビッグモデルに何をもたらすのでしょうか? Gemmaがリリースされてから 4 日が経ちました。Google が待ち望んでいたこのオープンソースは、世界中のテクノロジー コミュニティに衝撃を与えたと言えます。 最初に公開されたとき、Googleの関係者とジェフ・ディーン氏は、Gemma 7Bが同レベルのLlama 2とMistralを上回ったことを強調しました。 最も人気のあるオープンソースの大型モデル Llama 2 と詳細を比較すると、総合的な能力、推論、数学、プログラミングの面で完全な勝利を収めています。 テクノロジーの巨人が制作し、外部に完全にオープンで、商用利用が無料、ラップトップで実行可能...さまざまな福祉ラベルが追加されたことで、世界中の「観客」を興奮させています。 最近、多くのネットユーザーもジェマに対する様々な評価を始めている。 たとえば、ある人が Ollama を使用して Macbook で Gemma 7B を実行しました。タスクは、記事の冒頭のテキストに基づいて記事の種類を判断することでした。 そして体験後の評価を次のように述べました。

ネットユーザーの中には、ジェマとミストラルを比較した結果、次のような発見をした人もいる。

これらのパフォーマンスを見て、ネットユーザーはため息をつくほかない。

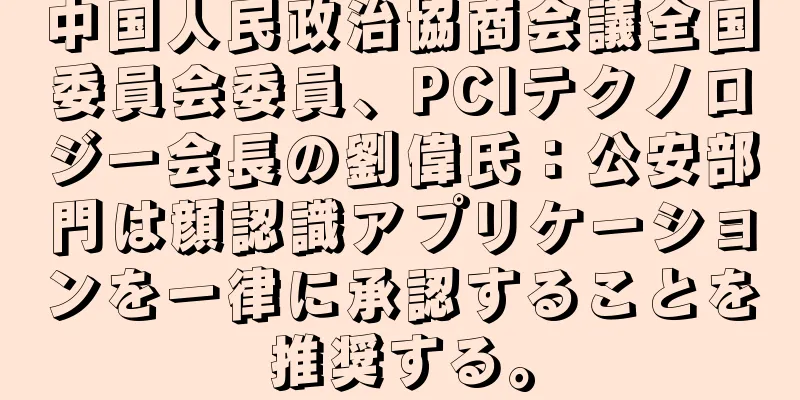

結果は十分に励みになるものの、オープンソースのビッグモデルに関しては、世界の注目は依然として海外からの「トップストリーム」に集中しているようだ。 すぐに浮かぶ疑問は次の通りです。 中国のオープンソースビッグモデルはどのように進んでいるのでしょうか?オープンソースのビッグモデルの分野では、主流の欧米のテクノロジー大手に加え、中国の「プレーヤー」も長い間地位を占めてきました。 では、ジェマの登場によって、チャートのランキングに波はありましたか? 結果はちょっと予想外だった - HuggingFace のオープンソース大規模モデルランキングでは、 Gemma は 70 億の事前トレーニング済みモデルの中で 3 位にランクされています。 1位と2位は、SenseTimeと上海AI実験室などが共同で開発した国内の大規模モデルプレイヤー「 InternLM2 (Shusheng·Pu Yu 2.0)」が獲得した。 では、オープンソースアーティストのトップに躍り出たジェマは、どのような点でポイントを失ったのでしょうか? 平均スコアを確認した後は、サブセグメントの状況も引き続き確認していきましょう。 まず、総合力(一般)では、InterLM2-7Bが65.8点を獲得し、Gemma-7Bをわずかに上回りました。 第二に、推論能力(Reasoning)の2つのベンチマークでは、InternLM2-7Bが1勝1引き分けを達成しました。 次は数学能力(Math)ですが、こちらもベンチマークが2つあります。InternLM2-7BはGSM8K評価ベンチマークで16ポイントを大きく上回っています。 最後に、プログラミング能力(コード)については、InternLM2-7B が 10 ポイントも高くなりました。 Llama-2 7B も含めると、InterLM2-7B はあらゆる面で完全な勝者となります。 それだけでなく、7B InternLM2 をより大きな 13B Llama-2 と比較しても、すべてのサブスコアで勝っています。 より直感的に言えば、InterLM2 と Gemma のパフォーマンス比較は次のようになります。 サプライズですか?実は、驚くことではありません。 なぜなら、Gemma がリリースされる前から、国内のオープンソースのビッグモデルはすでにさまざまなリストにランクインしており、一時的な流行ではなかったからです。 たとえば、InternLM2 は今年 1 月 17 日にリリースされ、2 つのパラメータ仕様、3 つのモデル バージョン、合計 6 つのモデルが用意されており、すべて商用利用が無料です。

当時、世界中の多くの7B体重級選手との競争において、InternLM2は「大きな円が小さな円を包む」姿勢を使用することで、パフォーマンスにおいて一定の優位性を獲得しました。 さらに、ChatGPT との比較プロセスでは、推論、数学、コードなどの主要な機能において ChatGPT を上回っています。 たとえば、InternLM2-Chat-20B は MATH と GSM8K で ChatGPT よりも優れたパフォーマンスを発揮します。コード インタープリターと併用すると、GPT-4 と同等のレベルに到達できます。 InternLM2 は 200K の超長いコンテキストもサポートしており、200 ページの財務レポートを簡単に読み取ることができます。 20万件のテキスト全体の重要情報の想起精度は95.62%に達しました。 たとえば、実際のアプリケーションでは、InterLM2 は 3 時間の会議記録や 212 ページの財務レポートを簡単に保存できます。 計算機などの外部ツールに頼ることなく、複雑な数学の問題を計算して解くことができます。 たとえば、100 以内の数学演算ではほぼ 100% の精度を達成でき、1000 以内では精度は 80% に達します。 コードインタープリターと併用すると、20B モデルは積分などの大学レベルの数学の問題を解くことができます。 これはどうやって行うのですか?研究チームから、彼らの戦略の鍵となるのはボリュームモデルのパラメータではなく、データであることがわかりました。 チームの見解では、非常に優れたバージョンのデータを抽出した後、さまざまな仕様のモデルのトレーニングをサポートできます。

チームは高度なデータクリーニングおよびフィルタリング システムを開発しており、その中核となる作業は次の3 つの主要部分に分かれています。

この「3 段階」のシステム設計により、データ セットがそれに応じて最適化され、より豊富で正確なものとなり、モデルのトレーニングとアプリケーションのサポートが向上します。 もちろん、InternLM2 の開発は、モデルの基本性能の向上に限定されず、現在のアプリケーションのトレンドに対応し、特定の下流タスクのパフォーマンスを強化します。 例えば、超長いコンテキストの処理に対する現在の一般的な需要に応えて、チームは、ツール呼び出しや数学的推論などのアプリケーションシナリオでは、より長いコンテキスト情報を処理する必要があることを指摘しました。 この課題に対処するために、InternLM2 は、トレーニング データの品質と構造化された関係を確保しながら、トレーニング ウィンドウの容量を拡張し、位置エンコード技術を改善することで、コンテキスト ウィンドウのサポート容量を 200,000 トークンまで拡張することに成功しました。 これにより、モデルの長いテキストを処理する能力が向上するだけでなく、全体的なトレーニング効率も最適化されます。 これが、トップスターのジェマと対決しながらも、InternLM2がデビュー以来ずっとトップの座を維持できた理由です。 結論最後に、記事の冒頭の質問に答えましょう。 Gemma はオープンソースのビッグモデルに何をもたらすのでしょうか? まず、トレンドです。 ビッグモデルが普及して以来、オープンソースとクローズドソースの話題は続いています。 OpenAI の ChatGPT、GPT-4 などはクローズドソースの大規模モデルの代表であり、その強みは誰の目にも明らかです。以前は Llama、Mitral などがオープンソースの大規模モデルの代表でした。 AIの巨人であるGoogleは、大手モデル巨人同士のこれまでの争いに少し疲れたようだ。結局のところ、ベンチマーク製品としてのGeminiは、OpenAIの主導的地位を揺るがすものではなかったようだ。 今回、Google は珍しく自社のビッグモデルをオープンソース化し、オープンソースコミュニティの他のプレイヤーと競争するために Gemma をリリースしました。これまでに公開された結果から判断すると、Google は一定の優位性を獲得しています。 同時に、オープンソース プロジェクトが大規模モデルの開発において重要な役割を果たしていることも側面から反映しています。 2つ目は自信です。 おそらく多くの人々は、依然として主流の海外テクノロジー大手の大型モデルの開発に留まったり、注力したりしているのでしょう。 しかし、各種ランキングや評価のデータから判断すると、中国の大型モデルも強い競争力を持っている。 InternLM2-7Bのオープンソースモデルだけではありません。国内の大手モデルメーカーも、さまざまなパラメータやサイズのモデルを競い合っています。 そして結果から判断すると、彼らはすでに中国語と英語の総合的な能力において全面的な進歩を達成しています。 この観点から見ると、Gemma のリリースは、オープンソース ビッグモデル業界における新たな強力なプレーヤーであるだけでなく、中国のオープンソース ビッグモデル、さらには AI ビッグモデル業界全体に自信をもたらします。 総じて、年初から現在までのわずか2か月間で、大型モデルの戦場がますます活発になっていることを非常に直感的に感じることができます。 国産か外国産か、オープンソースかクローズドソースか、あるいはさまざまなマルチモダリティかに関わらず、GeminiからGemmaへ、SoraからStable Diffusion 3へ、大手テクノロジー企業が互いに追いかける傾向が強まっています。 しかし、一つ明らかなことは、すべてのリリースが推論とテクノロジーの使用方法に重点を置く傾向にあるということです。 したがって、おそらくビッグモデルの次のプロセスでは、自社の製品を「速く、良く、経済的」に使用できるようにできた人が最後に笑うことになるだろう。 |

<<: 人間と踊る!中国の6団体が制作したヒューマノイドロボットがストリートショーに進出

>>: ジェネレーティブAIは伝統的な医師と患者の関係を破壊している

推薦する

ロボット犬をDIYするにはどれくらいの費用がかかりますか?価格は900ドルと安く、スタンフォード大学が開発し、コードはオープンソースです

たった 900 ドルで四足ロボット犬を DIY できる?スタンフォード学生ロボットクラブの新メンバー...

カメラの前で指をタップすることでパーキンソン病の症状を遠隔で評価するAIツールが開発される

9月10日、ロチェスター大学の研究者らは、パーキンソン病患者が数分で遠隔から症状の重症度を評価できる...

ThunderSoft の Sun Li: AI 対応産業の課題と解決策

[51CTO.comからのオリジナル記事] 現在、人工知能はセキュリティ、金融などのサブセクターを強...

パンデミック後、アメリカ人の半数がスマートデバイスの音声制御が不可欠だと考えている

Syntiantが最近実施したユーザー調査によると、COVID-19パンデミックの影響により、アメリ...

マイクロソフトは、劣化が著しい古い写真を復元できる新しいアルゴリズムを開発した。

海外メディアの報道によると、マイクロソフト研究チームのZiyu Wan氏、Zhang Bo氏らは、デ...

人工知能がインダストリー4.0における製造業に革命をもたらす

人工知能 (AI) という用語は、流行語の地位を超え、業界全体にわたる技術革新の基礎となっています。...

TensorFlowはディープラーニングに基づく画像補完を実装する

[[191845]]目次■ はじめに■ ステップ1: 画像を確率分布のサンプルとして理解する不足して...

MozillaのAIヘルプツールがついに正式に無効化:生成された技術情報は真実と虚偽が混在

7月7日、MDN Web Documentation Project(旧称Mozilla Deve...

2025年までにロボットが8000万人の労働者に取って代わるのでしょうか?職を失った人はどうすればいいのでしょうか?

同紙によると、世界経済フォーラムがロボット革命に関する報告書を発表し、世界的な警戒を呼び起こした。同...

なぜモノのインターネット、ビッグデータ、人工知能は常にグループで表示されるのでしょうか?

[[274332]]私のいとこは 2000 年代生まれで、大学に入学したばかりの才能あふれる若者で...

AIディープフェイク技術の2つの側面

著者 | 李世馨翻訳者 | 朱 仙中編纂者:Qianshan人工知能に関する議論にはしばしば論争が伴...