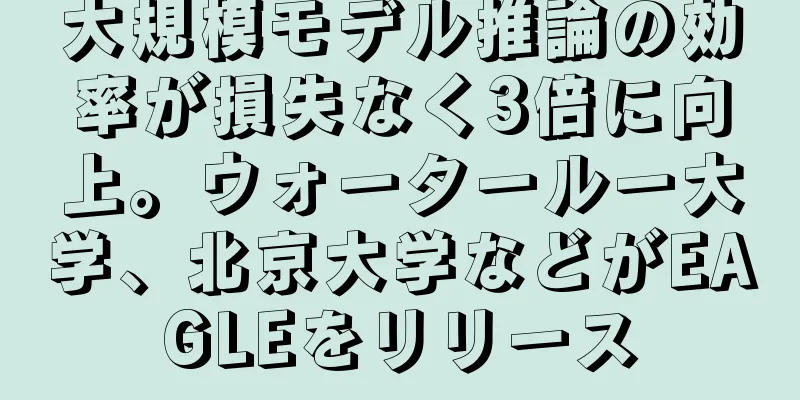

TensorFlow プロダクト マネージャー: 今後 10 年間で機械学習はソフトウェアとハードウェアをどのように変えるのでしょうか?

|

最近、Google Brain の従業員であり TensorFlow プロダクト マネージャーでもある Zak Stone 氏が、シリコンバレーの起業家コミュニティである South Park Commons で講演を行い、TensorFlow、XLA、Cloud TPU、TFX、TensorFlow Lite などのさまざまな新しいツールやトレンドが機械学習の未来をどのように形作っているのかについて語りました。同時に、彼はまだ公表されていないいくつかの興味深い事柄についてもほのめかした。 講演のタイトルは「Tensor Flow、Cloud TPU、ML の進歩」です。以下は、South Park Commons の公式ブログからまとめた講演全体の要約です。 プラットフォームとして、TensorFlow は大きな賭けです。高速で、柔軟性があり、本番環境で使用できるものでなければなりません。実験と実行の間の移行は、エンジニアリングの生産性を確保するのに十分な速さでなければなりません。静的画像の計算は、Python などの高水準で柔軟な言語で表現され、グラフのコンパイルにより、特定の目標に対する精度の最適化が可能になります。 オープンソース プロジェクトとして、TensorFlow は非常に成功しています。2015 年 11 月のリリース以来、Github で 20,000 件を超えるコミットを獲得しています。 TensorFlow の Github バージョンは、少なくとも週に 1 回、Google の内部イメージ ファイルと双方向に同期されます。同時に、TensorFlow は、Intel、Microsoft、IBM、Rstudio、Minds.ai などの企業の R&D チームから、あらゆる規模の貢献も受けています。 より多くのユーザーにリーチするために、モバイル デバイスで TensorFlow モデルを実行する効率を向上できる TensorFlow Lite が今年後半にデバイスに組み込まれる予定です。XLA などのプロジェクトはさらに野心的です。XLA はディープラーニングを使用して線形代数要素の事前コンパイルとジャストインタイム コンパイルをサポートし、任意のターゲット バックエンド システム用の高速コードを生成します。 XLA の目標は、GPU アーキテクチャだけでなく、線形代数要素を並列化できるあらゆるアーキテクチャにおいて、階層的最適化における大きな進歩を達成することです。 Google では、CEO の Sundar Pichai 氏の「AI ファースト」企業になるという呼びかけの下、多くのプロジェクトに TensorFlow が適用されています。 機械学習ベースのソフトウェア開発の加速化の傾向は、Googleだけに起きているわけではありません。Amazon、Apple、Baidu、Facebook、Microsoft、Salesforce、Uber、Lyftなど、ほとんどすべての主流テクノロジー企業も、機械学習の産業化を推進するために専門的な研究開発チームを採用しています。これらの企業の中には、Facebook の PyTorch や Caffe2、Microsoft の CNTK、Apple の Core ML、Amazon の MXNet など、さまざまなディープラーニング開発プラットフォームがあります。 今後 10 年間のソフトウェア エンジニアリングはどのようになるでしょうか? 機械学習の台頭は、元々のクリーンな抽象化とモジュール設計が、高次元浮動小数点テンソルと効率的な行列乗算に置き換えられていることを意味します。 この傾向が続けば、ソフトウェアエンジニアリング業界は変化するでしょう。 Google のソフトウェア エンジニアである D. Sculley 氏はかつて、「機械学習: 技術的負債という高利のクレジットカード」というタイトルの記事を執筆し、機械学習システムが不適切なソフトウェア設計を誘発し、さらには不適切な設計を必要とするさまざまな可能性を列挙しました。同氏は、「これらのシステムの基本コードは通常のコードと同じ複雑さだが、システムレベルではより複雑であり、潜在的なリスクにつながる可能性がある」と述べた。(https://research.google.com/pubs/pub43146.html) 機械学習システムは、すべてのシステム入力を緊密に結合することでモデルの境界と抽象化を曖昧にします。望ましい動作の不変量は、ソフトウェア ロジックからではなく、それを駆動する特定の外部データから得られます。静的分析とグラフ接続を使用してコードの信頼性を識別するツールはありますが、一般にこれらのツールにはデータの相関関係を分析する機能はありません。 D Sculley らは論文の中で、システム設計におけるいくつかの欠点について論じており、それは関連する実務家の共感を呼んでいます。 1. グルー コード システム設計スタイル、「さまざまな目的でインストール パッケージとの間でデータを転送するために、大量のサポート コードを記述する必要がある」 2. パイプラインのジャングルは時間の経過とともに有機的に進化し、データ準備システムは「スケープ、結合、サンプリングのステップが絡み合った混乱状態になり、中間ファイル出力が発生することがよくあります」。 3. システムや生産ラインの開発に伴って蓄積される構成負債とは、「使用する機能、データのフィルタリング方法、特定の学習アルゴリズムの設定(範囲は多岐にわたる)、潜在的な前処理または後処理、検証方法など、さまざまなコンパイル オプション」の集合です。 より小規模で軽量なプロジェクトであっても、エンジニアは依然として次のような問題に悩まされています。 1. 実験で使用されるモデル アーキテクチャと重みのバージョン - 特に、モデルが別のシステムからトレーニング モデルの一部を借用する場合、または他のモデルから重みを借用する場合。 2. データ ソースと機能バージョン。 3. 実験環境と本番環境間の移行(ドメインシフト) 4. 運用中の推論の品質を監視します。 これらの問題に対する解決策の 1 つは、機械学習モデルを本番環境で配布および提供するために Google 社内で開発されたプラットフォームである TFX です。 機械学習モデルを確実に作成および展開するために使用できるプラットフォームを作成および管理するには、トレーニング データに基づいてモデルを生成する学習者、データとモデルを分析および検証するためのモジュール、そして最終的にはモデルを運用環境に展開するためのインフラストラクチャなど、多くのコンポーネント間の慎重なオーケストレーションが必要です。データが時間の経過とともに変化し、モデルが継続的に更新されると、プラットフォームの管理が非常に困難になります。 残念ながら、これらの取り決めは通常、グルーコードと特定のスクリプトファイルを通じて 1 つずつ処理されるため、複製コストが高くなり、システムが脆弱になり、多くの技術的リスクが発生します。 TFX はこれらのプロセスとコンポーネントを標準化し、単一のプラットフォームに統合することで、プラットフォームのコンパイル プロセスを簡素化し、生産時間を数か月から数週間に短縮するとともに、プラットフォームの信頼性を確保し、サービスのクラッシュを削減します。 今後 10 年間でハードウェアはどのように変化するでしょうか? ムーアの法則の減速により、私たちは「アーキテクチャの黄金時代」に再び突入し、さまざまなチップや命令セットの急速な発展を目の当たりにできるようになりました。 Intel の Nervana、Nvidia、Cerebras、Google などの企業はいずれも、機械学習で使用される線形代数演算を高速化できる次世代ハードウェア アーキテクチャに取り組んでいます。また、デフォルトでは、各アーキテクチャには、cuDNN のような独自の低レベルの手動で最適化されたプリミティブ ライブラリが必要です。 (cuDNN は CUDA Deep Neural Network ライブラリの略で、NVIDIA がディープ ニューラル ネットワーク専用に設計した GPU コンピューティング アクセラレーション ライブラリのセットです。) この傾向を打破するには、同業者が XLA などのより汎用的なコンパイラ フレームワークの開発にさらに力を入れる必要があります。 Google の TPU (Tensor Processing Units) は現在、GPU の優位性を打ち破る可能性が最も高いです。各 Cloud TPU は、1 秒あたり最大 180 兆回の浮動小数点演算、64 GB の超高帯域幅のストレージ スペース、およびカスケード可能な機能を提供できます。これまでのスーパーコンピュータ アーキテクチャとは異なり、TPU は機械学習で一般的な線形代数演算専用にゼロから設計されました。 TPUはTensorFlowと統合されており、Googleは有料のクラウドサービス(Cloud TPU)を提供しています。同時に、TensorFlow Research Cloud(TFRC)プロジェクトを通じて、TPUを事前に利用したい機械学習の専門家に補助金を支給し、1,000台のCloud TPUを提供し、彼らが研究成果を論文やオープンソースソフトウェアを通じて世界に発信することを期待しています。 まとめ グラフ コンピューティングと TensorFlow のようなディープラーニング ライブラリは、コンピューティング業界の将来の発展の主な原動力であり、ハードウェアからコンパイラ、高レベルのプログラミング言語、設計仕様に至るまで、システム アーキテクチャを再検討する原動力となります。 したがって、ソフトウェア アーキテクト、エンジニア、研究者、その他の実務者にとっては大変な作業となりますが、同時にそのプロセスは非常に刺激的なものでもあります。ザック氏はスピーチの中で次のように要約した。 これらの素晴らしいアプリケーションのほとんどは、私が大学院生だったときには実現できませんでした。人々が機械学習の技術に慣れ、今では予測できないようなことをし始めたらどうなるでしょうか。最初の TensorFlow ネイティブ製品はどのようなものになるでしょうか。」 |

<<: Python での機械学習 K-means アルゴリズムの実装

>>: こんにちは。タクシーに乗って空へ行きたいです。右へ飛んでください。

推薦する

AI は、市場にスパムを氾濫させ、情報を捏造することを学習します。 Google の新しい調査で、現実世界の AI アプリケーションの落とし穴が明らかに

[[430918]]今日、機械学習 (ML) モデルは大規模に使用され、影響力がますます高まっていま...

人間は AI シミュレーションの中で生きられるのか?

人々が自らに問うべき実存的な問いは、自分たちがシミュレートされた宇宙に住んでいるかどうかだ。 [[3...

人工知能技術の登場によるデジタル変革をどう理解すればよいのでしょうか?

デジタル化は、意思決定レベルから産業レベルまでの変化において中心的な課題になりつつあります。科学技術...

クラウドコンピューティングと人工知能が、先進的な企業に前例のない機会を生み出す方法

近年、ますます大規模なデータセットを処理するために SaaS (サービスとしてのソフトウェア) モデ...

年次指数レポートではAIが「産業化」しているが、より優れた指標とテストが必要とされている

海外メディアVentureBeatによると、中国は人工知能の研究論文の総数で米国を上回り、資金提供を...

将来、AIと競争して仕事を得るための16の実践的なヒント

[[256943]]現在、多くの企業がすでに人工知能と機械学習を活用しており、これらのテクノロジーの...

MITのロボット犬がまた進化しました。砂利や氷の上でも滑らずに走れます。今回は本当に犬と同じくらい安定しています

この記事はAI新メディアQuantum Bit(公開アカウントID:QbitAI)より許可を得て転載...

「順序付きファネル」アルゴリズム問題は、iResearch A10サミットで新たなブレークスルーを達成すると期待されています。

新小売、新金融、新エンターテインメントなどの新しい業態の台頭により、ビッグデータの驚異的な力がインタ...

JD.comのインテリジェント顧客サービスブランドがリニューアル:「Yanxi」が2020 JDDカンファレンスでデビュー

「言葉の含意は心が繋がっている」という意味で、言葉がテレパシーのような共鳴を呼び起こし、人と人の間の...

トレーニングなしでリアルタイムに動的値のアライメントを実現:オープンソースの値アライメント手法OPOは、クローズドソースとオープンソースの両方の大規模モデルで利用可能

人工知能技術の発展により、GPT-4に代表される大規模言語モデルはその強力な機能で社会に大きな影響を...

劉強東:人工知能の時代が来ています。このチャンスをつかめば、あなたは豊かになれます。

劉強東は言った。「この世で働かずに得られる唯一のものは貧困であり、無から創造できる唯一のものは夢であ...